公司网站建设好后却不被收录-网页去重算法、指纹算法了解一下?

公司网站建设好之后页面不被收录,原因有很多种,包括页面代码结构导致抓取困难,页面加载速度过慢,相应时间长,请求次数过多,有时甚至只是因为网站建设上线后robots忘记修改,原因有很多种,对网站进行SEO优化并不是单纯的一两件事,更多的是对网站潜在问题的提前发觉与调整,在这篇文章里我们就一起来了解下网页去重算法与指纹算法对网站的影响及应对方法。

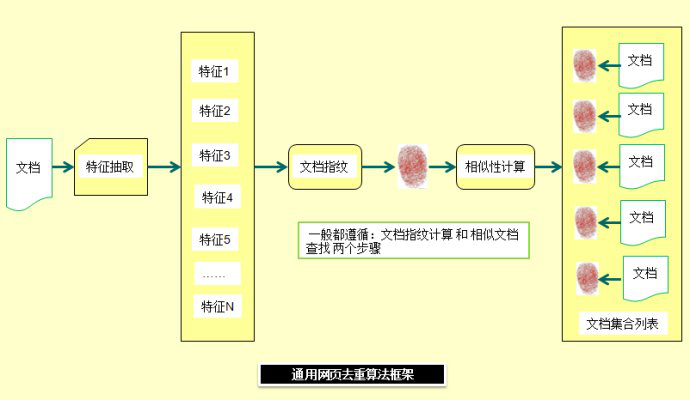

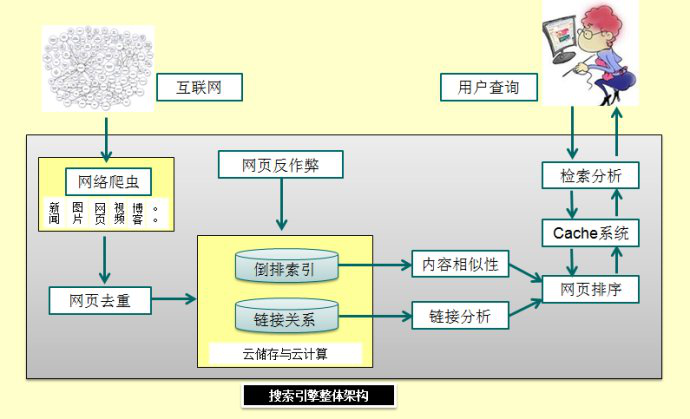

我们知道,搜索引擎爬虫程序在发现一个新的网页的时候,抓取系统会经过多层计算判断页面内容,这一点可以在早期的内容:抓爬系统概述中了解,而在抓取完内容后,程序将会自动对比网站网页与搜索引擎收录数据库中的内容相似度,通过网页去重算法,最终决定是否对其索引。

一般来讲,常见的近似重复网页根据页面内容和网页布局样式有四种形式:

第一种:两个网站页面的建设在内容与布局样式毫无差别,这种重复属于完全重复页面,不仅很难被收录,且容易被认定为采集或镜像站点受到算法惩罚。

第二种:两个网站页面的建设在内容上相同,但布局样式不同,这种重复属于内容重复页面,一般来说这样的网站内容建设不会被认定为镜像其他站点,但仍有可能被认定为采集站点。

第三种:两个网站页面的建设在内容上有部分内容相同,且布局格式基本相同,这种重复则属于布局重复页面,一般来讲模板建站会有这种问题发生,这类模板站点一般是被大量套用的,这也就是为什么定制站点排名往往更快的原因之一。

第四种:两个网站页面的建设在内容上有部分相同,但布局完全不同,这种重复则为部分重复页面,常见于伪原创优化站点之中,伪原创程度不够的情况下则可能受到百度飓风算法打击。

做搜索引擎优化是从运营的角度进行深度的分析剖解,对于搜索引擎而言,重复的网站内容建设有什么不利影响呢?其实不难想出。

我们知道国内搜索引擎的巨头某度如今主要的盈利手段是搜索引擎关键词竞价推广,网站站长们在某度投放竞价广告的理由无非是访问者的潜在商业价值,早些年莆田事件也让这一产业链公诸于世,但我们知道某度这么差劲还是有人用是为什么,因为人们有信息检索的需求,我们从搜索引擎的角度进行思考便能得出结论了:

如果我收录的网站建设的基础都是单纯的广告,那又有谁去用呢?产品的根本是用户体验,相似或是重复的网站页面内容往往为访问者提供的价值是极低或是没有的,而对这些内容进行爬取、收录和索引还会耗费大量的服务器资源,这显然是不值当的。

那么问题就来了,如果我们公司网站建设的时候是采取的定制化网站设计却被其他人恶意套站呢?其实大可不必担心这种事情,如果你的网站作为该内容最早被收录的页面却被其他网站采编收录,往往会认定为这是比较受欢迎的内容,也预示着该物业是比较重要的,应该给予优先排名,在用户搜索结果中会获得更高的排序。

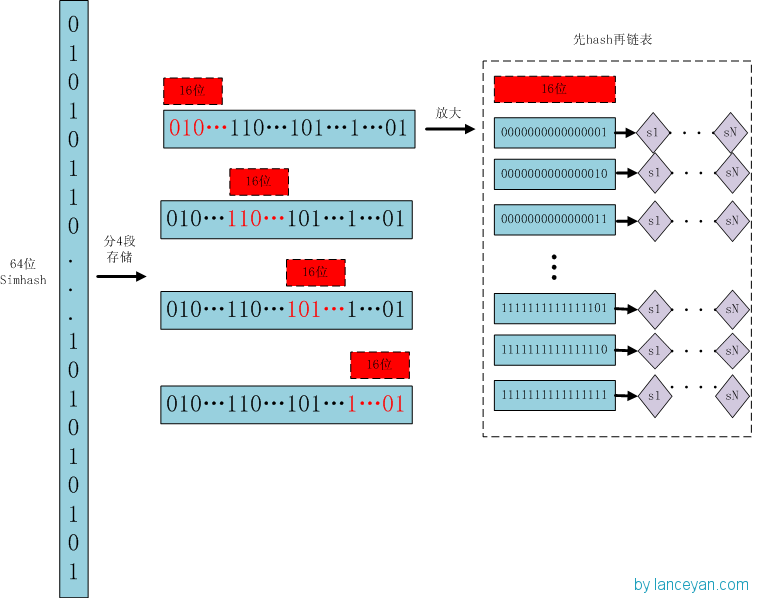

但就技术层面而言,搜索引擎在判断海量数据的相似度的时候是如何计算的?一般来讲SimHash和海明距离是常见的方法。

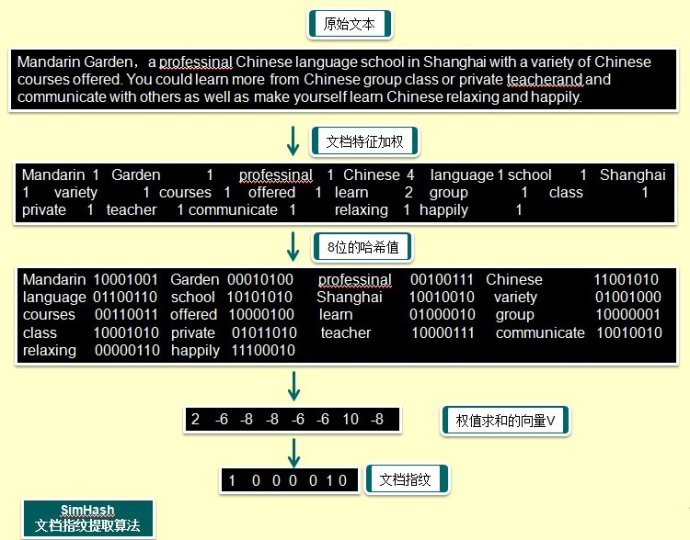

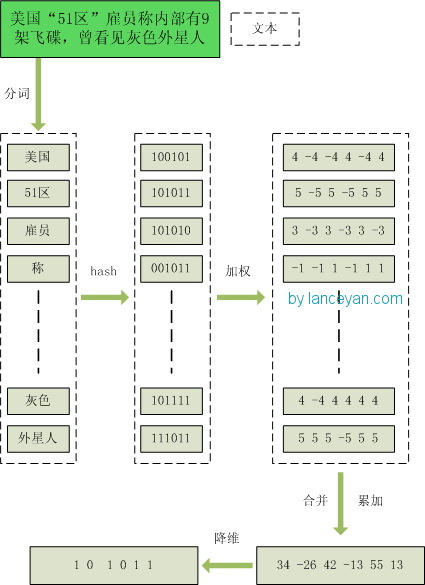

Simhash指纹:该计算方法是通过网站页面中提取具有权值的特征集群来代表该页面,一般而言词的权值由出现频率TF决定。其次对于每一个词通过哈希值算法生成二进制数据,并计算相应的每维向量。Simhash计算的速度很快,也是目前用来网页去重最常用的hash方法。

海明距离:在信息编码中,两个合法代码对应位上编码不同的位数称为码距,又称海明距离。一般用于用于编码的检错和纠错,两个码字的对应比特取值不同的比特数,在一个有效编码集中,任意两个码字的海明距离的最小值称为该编码集的海明距离。

如果对与网站优化问题还有所不理解或是想寻求业务合作的,可以联系耀年数字客户,我们的AE将尽快与你联系。

公网安备 44030402005195 号

公网安备 44030402005195 号